Ebben a korszakban a Transformers a legerősebb modellek, amelyek a legjobb eredményeket biztosítják több NLP (Natural Language Processing) műveletben. Kezdetben nyelvi modellezési feladatokhoz használták, beleértve a szöveggenerálást, valamint az osztályozást, a gépi fordítást és még sok mást. De most már tárgyfelismerésre, képosztályozásra és számos egyéb számítógépes látási feladatra is használják.

Ebben az oktatóanyagban bemutatjuk a Transformers segítségével történő szövegosztályozás végrehajtásának eljárását.

Hogyan végezzünk szövegosztályozást transzformátorokkal?

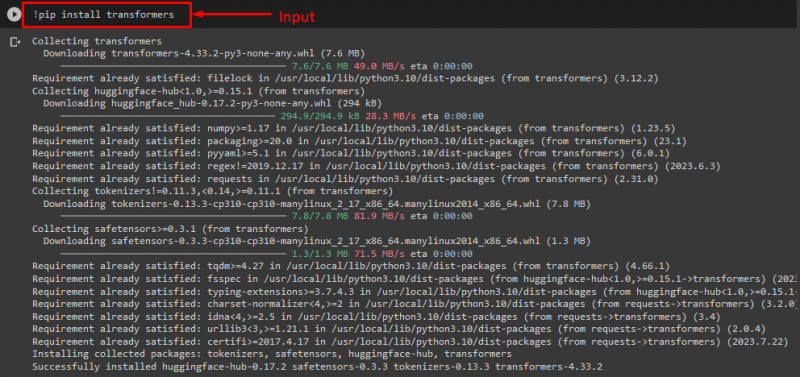

A Transformers segítségével történő szövegosztályozás végrehajtásához először telepítse a „ transzformátorok ” könyvtárat a megadott parancs végrehajtásával:

! csipog telepítés transzformátorok

Mint látható, a megadott könyvtár sikeresen telepítve lett:

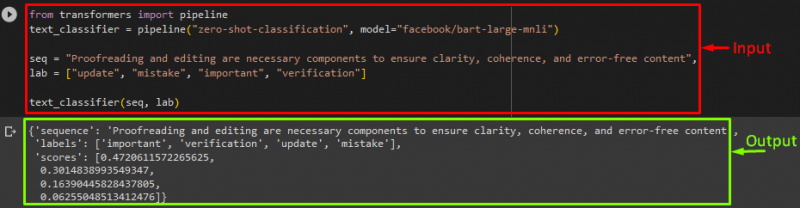

Ezután importálja a „ csővezeték ' tól ' transzformátorok ” könyvtár:

transzformátor import csővezetékből

Itt a „ csővezeték ” tartalmazza az NLP feladatot, amelyet el kell végeznünk, és a kívánt transzformátormodellt ehhez a művelethez a tokenizátorral együtt.

Jegyzet: A tokenizátor a szöveg tokenekre történő szétválasztásával a modell által bevitt szöveg feldolgozására szolgál.

Ezt követően használja a „ csővezeték() ' függvényt, és adja át a ' zéró-lövés-besorolás ” érvként. Ezután adjon meg egy másik paramétert, amely a modellünk. A Facebookot használjuk BART ” transzformátor modell. Itt nem használjuk a tokenizert, mert a megadott modell automatikusan kikövetkeztetheti:

text_classifier = csővezeték ( 'nullalövés-besorolás' , modell = 'facebook/bart-large-mnli' )

Most jelentse ki a „ szekv ” változó, amely tartalmazza a bemeneti szövegünket, amelyet osztályozni kell. Ezután megadjuk azokat a kategóriákat, amelyekbe a szöveget be kívánjuk sorolni, és a „ labor ', amely címkékként ismert:

labor = [ 'frissítés' , 'hiba' , 'fontos' , 'igazolás' ]

Végül futtassa a folyamatot a bemenettel együtt:

A folyamat végrehajtása után, amint látható, a modell megjósolta, hogy a megadott sorozatunk besorolásra kerül:

További információ: Ha fel akarja gyorsítani a modell teljesítményét, akkor a GPU-t kell használnia. Ha igen, akkor ebből a célból megadhat egy eszköz argumentumot a folyamatban, és beállíthatja a ' 0 ” a GPU használatához.

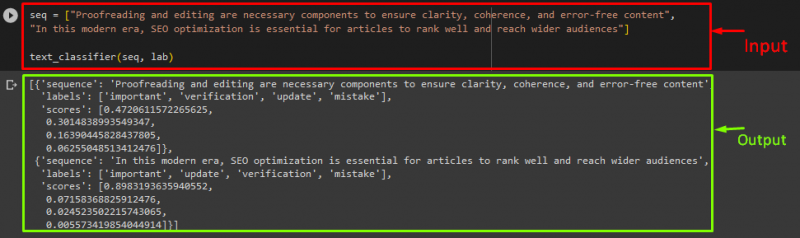

Ha a szöveget egynél több szekvencia/bemeneti szöveg utasításra szeretné besorolni, akkor felveheti őket egy listára, és bemenetként továbbíthatja a folyamatokhoz. Ebből a célból nézze meg a kódrészletet:

szekv = [ 'A lektorálás és a szerkesztés szükséges összetevők az egyértelműség, koherencia és hibamentes tartalom biztosításához' ,'E modern korszakban a SEO optimalizálás elengedhetetlen ahhoz, hogy a cikkek jó helyezést érjenek el és szélesebb közönséget érjenek el' ]

text_classifier ( szekv , labor )

Kimenet

Ez az! Összeállítottuk a szövegbesorolás legegyszerűbb módját a Transformers segítségével.

Következtetés

A transzformátorokat nyelvi modellezési feladatok, például szöveggenerálás, szövegosztályozás és gépi fordítás, valamint számítógépes látási feladatok elvégzésére használják, beleértve az objektumfelismerést és a képosztályozást. Ebben az oktatóanyagban bemutattuk a Transformers használatával végzett szövegosztályozás folyamatát.