Ez az útmutató bemutatja a beszélgetési tudásgráf LangChain használatának folyamatát.

Hogyan kell használni a beszélgetési tudásgráfot a LangChainben?

A BeszélgetésKGMemory könyvtár használható a memória újbóli létrehozására, amely felhasználható az interakció kontextusának megszerzésére. A beszélgetési tudásgráf LangChainben való használatának megismeréséhez egyszerűen hajtsa végre a felsorolt lépéseket:

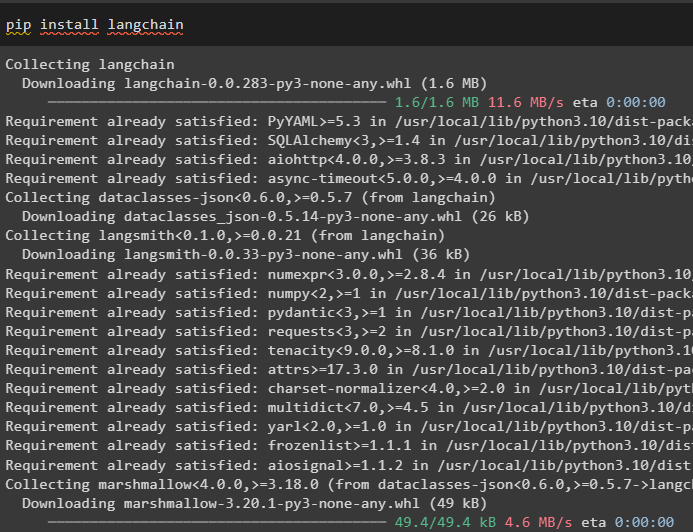

1. lépés: Modulok telepítése

Először is kezdje el a beszélgetési tudásgráf használatának folyamatát a LangChain modul telepítésével:

pip install langchain

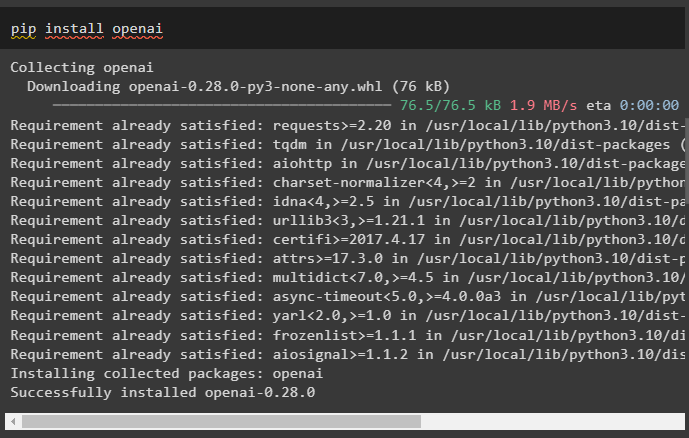

Telepítse az OpenAI modult, amely a pip paranccsal telepíthető, hogy megkapja a könyvtárait a nagy nyelvi modellek építéséhez:

pip install openai

Most, állítsa be a környezetet a fiókjából generálható OpenAI API-kulcs használatával:

import te

import getpass

te . hozzávetőlegesen, körülbelül [ 'OPENAI_API_KEY' ] = getpass . getpass ( 'OpenAI API kulcs:' )

2. lépés: Memória használata LLM-ekkel

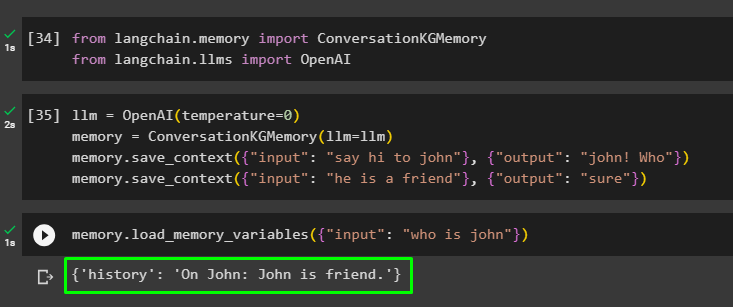

A modulok telepítése után kezdje meg a memória használatát az LLM-mel a szükséges könyvtárak importálásával a LangChain modulból:

tól től langchain. memória import BeszélgetésKGMemorytól től langchain. llms import OpenAI

Építse fel az LLM-et az OpenAI() metódussal, és állítsa be a memóriát a BeszélgetésKGMemory () módszer. Ezután mentse el a prompt sablonokat több bemenet használatával a megfelelő válaszukkal, hogy a modellt ezekre az adatokra tanítsa:

llm = OpenAI ( hőfok = 0 )memória = BeszélgetésKGMemory ( llm = llm )

memória. save_context ( { 'bemenet' : 'köszönj Johnnak' } , { 'Kimenet' : 'John! Ki' } )

memória. save_context ( { 'bemenet' : 'ő egy barát' } , { 'Kimenet' : 'biztos' } )

Tesztelje a memóriát a betöltésével memória_változók () metódus a fenti adatokhoz kapcsolódó lekérdezést használva:

memória. load_memory_variables ( { 'bemenet' : 'ki az a János' } )

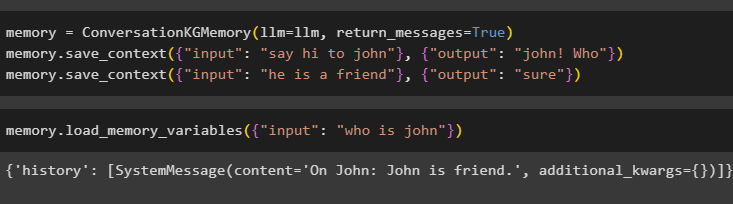

Konfigurálja a memóriát a ConversationKGMemory() metódussal a return_messages argumentum a bemenet előzményeinek lekéréséhez:

memória = BeszélgetésKGMemory ( llm = llm , return_messages = Igaz )memória. save_context ( { 'bemenet' : 'köszönj Johnnak' } , { 'Kimenet' : 'John! Ki' } )

memória. save_context ( { 'bemenet' : 'ő egy barát' } , { 'Kimenet' : 'biztos' } )

Egyszerűen tesztelje a memóriát úgy, hogy a bemeneti argumentum értékét megadja lekérdezés formájában:

memória. load_memory_variables ( { 'bemenet' : 'ki az a János' } )

Most tesztelje a memóriát úgy, hogy felteszi a kérdést, amely nem szerepel a képzési adatokban, és a modellnek fogalma sincs a válaszról:

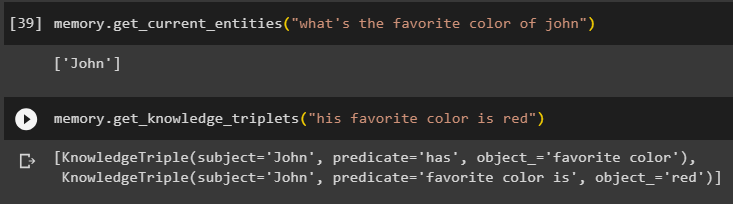

memória. get_current_entities ( 'mi a János kedvenc színe' )Használja a get_knowledge_triplets () módszer a korábban feltett kérdésre válaszolva:

memória. get_knowledge_triplets ( 'Kedvenc színe a piros' )

3. lépés: A memória használata a láncban

A következő lépés a beszélgetési memóriát használja a láncokkal az LLM modell felépítéséhez az OpenAI() metódussal. Ezt követően konfigurálja a prompt sablont a beszélgetési struktúra segítségével, és a szöveg megjelenik, miközben a modell kimenetet kap:

llm = OpenAI ( hőfok = 0 )tól től langchain. felszólítja . gyors import PromptTemplate

tól től langchain. láncok import Beszélgetési lánc

sablon = '''Ez az ember és a gép közötti interakció sablonja

A rendszer egy mesterséges intelligencia-modell, amely több szempontból is képes beszélni vagy információt nyerni

Ha nem érti a kérdést, vagy nem tudja a választ, akkor egyszerűen azt mondja

A rendszer kivonja a 'Speciális' részben tárolt adatokat, és nem hallucinál

Különleges:

{történelem}

Beszélgetés:

Ember: {input}

AI: '''

#Állítsa be a sablont vagy struktúrát az AI-rendszertől érkező felszólítások és válaszok megjelenítéséhez

gyors = PromptTemplate ( bemeneti_változók = [ 'történelem' , 'bemenet' ] , sablon = sablon )

beszélgetés_kg-mal = Beszélgetési lánc (

llm = llm , bőbeszédű = Igaz , gyors = gyors , memória = BeszélgetésKGMemory ( llm = llm )

)

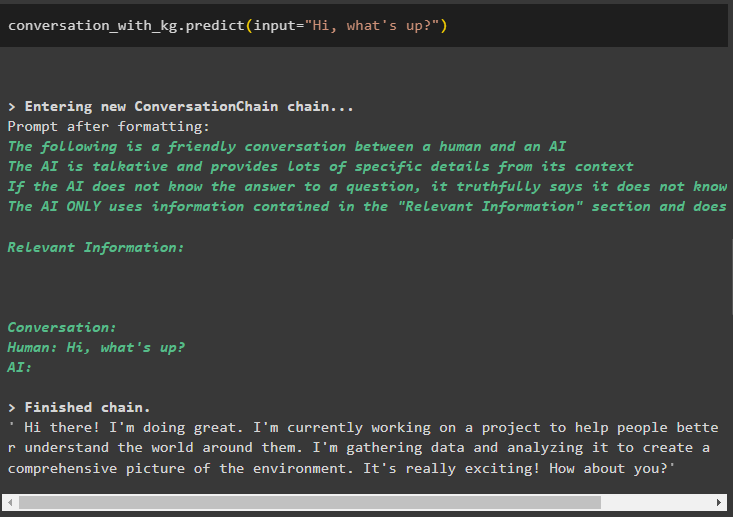

A modell létrehozása után egyszerűen hívja a beszélgetés_kg-mal modellezze a predikció() metódus használatával a felhasználó által feltett lekérdezéssel:

beszélgetés_kg-mal. megjósolni ( bemenet = 'Szia mi újság?' )

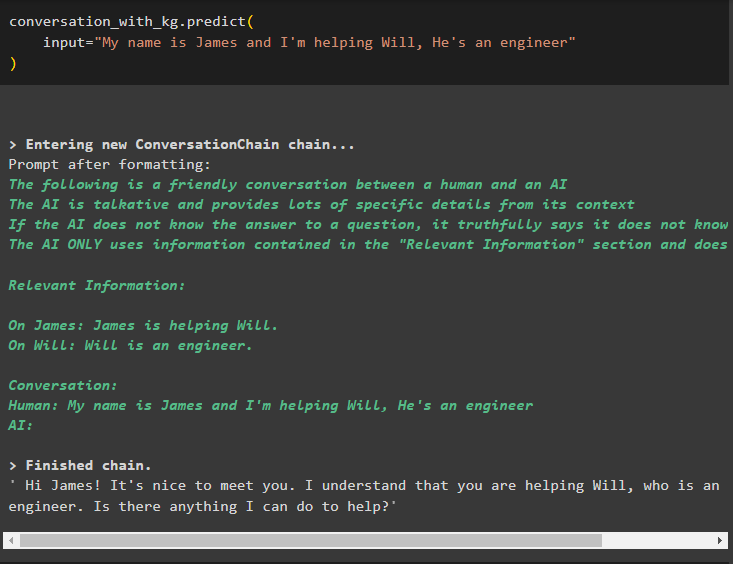

Most tanítsa meg a modellt a beszélgetési memória használatával, és adja meg az információt a metódus bemeneti argumentumaként:

beszélgetés_kg-mal. megjósolni (bemenet = 'A nevem James, és segítek Willnek, ő mérnök'

)

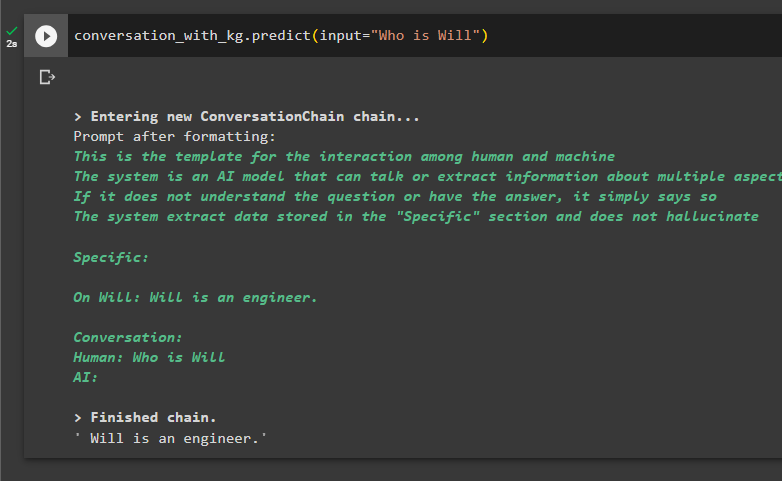

Itt az ideje tesztelni a modellt úgy, hogy megkérjük a lekérdezéseket, hogy információkat nyerjenek ki az adatokból:

beszélgetés_kg-mal. megjósolni ( bemenet = 'Ki az a Will' )

Ez minden a LangChain beszélgetési tudásgráfjának használatáról szól.

Következtetés

A beszélgetési tudásgráf LangChainben való használatához telepítse a modulokat vagy keretrendszereket a ConversationKGMemory() metódus használatához szükséges könyvtárak importálásához. Ezt követően készítse el a modellt a memória segítségével a láncok felépítéséhez, és a konfigurációban megadott betanítási adatokból információkat nyerjen ki. Ez az útmutató részletesen bemutatja a beszélgetési tudásgráf LangChain alkalmazásának folyamatát.