A pipeline() függvény a Transformer könyvtár szerves része. Több bemenetre van szükség, amelyekben következtetési feladatot, modelleket, tokenizációs mechanizmust stb. definiálhatunk. A pipeline() függvényt főként NLP feladatok végrehajtására használják egy vagy több szövegen. Előfeldolgozást végez a bemeneten és utófeldolgozást a modell alapján, hogy ember által olvasható kimenetet és pontos előrejelzést generáljon maximális pontossággal.

Ez a cikk a következő szempontokat tárgyalja:

- Mi az a Hugging Face Datasets Library?

- Hogyan alkalmazzunk csővezetékeket egy adathalmazra átölelő arcban?

Mi az a Hugging Face Dataset Library?

A Hugging Face adatkészlet-könyvtár egy olyan API, amely több nyilvános adatkészletet tartalmaz, és egyszerű módot biztosít ezek letöltésére. Ez a könyvtár importálható és telepíthető az alkalmazásba a „ csipog ” parancsot. A Hugging Face könyvtár adatkészleteinek letöltésével és telepítésével kapcsolatos gyakorlati bemutatóért látogasson el ide Google Colab link. Több adatkészletet is letölthet a Átölelő arcadatkészlet-központ.

További információ a pipeline() függvény működéséről ebben a cikkben ' Hogyan használjuk a Pipeline() funkciót a transzformátorokban? ”.

Hogyan alkalmazzunk csővezetékeket egy adathalmazra átölelő arcban?

A Hugging Face számos különböző nyilvános adatkészletet kínál, amelyek egysoros kód használatával egyszerűen telepíthetők. Ebben a cikkben egy gyakorlati bemutatót fogunk látni a folyamatok ezekre az adatkészletekre történő alkalmazásáról. A folyamatok kétféleképpen valósíthatók meg az adatkészleten.

1. módszer: Iterációs módszer használata

A pipeline() függvény egy adatkészleten és modellen is iterálható. Ebből a célból kövesse az alábbi lépéseket:

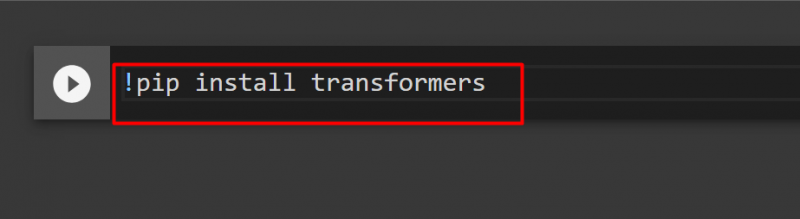

1. lépés: Telepítse a Transformer Library-t

A Transformer könyvtár telepítéséhez adja ki a következő parancsot:

!pip install transzformátorok

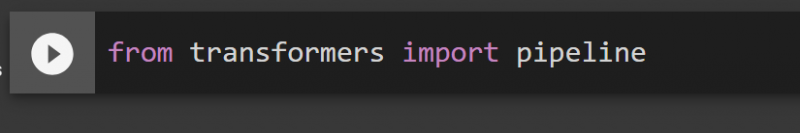

2. lépés: Csővezetékek importálása

Importálhatjuk a csővezetéket a Transformer könyvtárból. Ebből a célból adja ki a következő parancsot:

transzformátor import csővezetékből

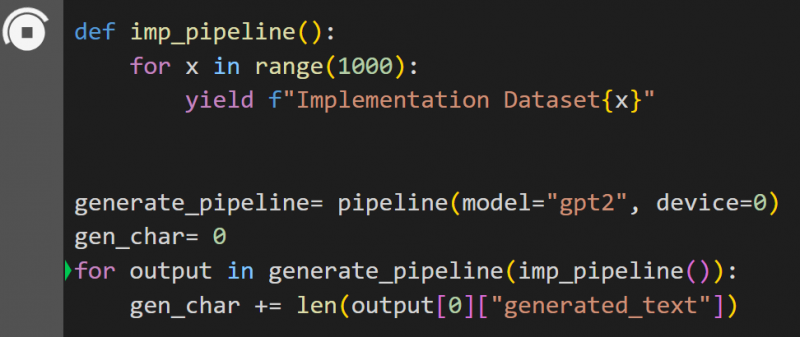

3. lépés: A csővezeték megvalósítása

Itt a pipeline() függvény a ' modellen van megvalósítva gpt2 ”. A modelleket innen töltheti le Ölelő arcmodell központ:

def imp_pipeline():x esetén a tartományban (1000):

hozam f'Implementation Dataset{x}'

gener_pipeline= pipeline(model='gpt2', device=0)

gen_char= 0

a gener_pipeline(imp_pipeline()) kimenethez:

gen_char += len(output[0]['generated_text'])

Ebben a kódban a „ gener_pipeline ' egy változó, amely tartalmazza a pipeline() függvényt ' modellel gpt2 ”. Amikor a „ imp_pipeline() ” funkcióval automatikusan felismeri az 1000-re megadott tartományban megnövelt adatokat:

Ennek edzése eltart egy ideig. A link a Google Co is adott.

2. módszer: Datasets Library használata

Ebben a módszerben bemutatjuk a folyamat megvalósítását az „adatkészletek” könyvtár használatával:

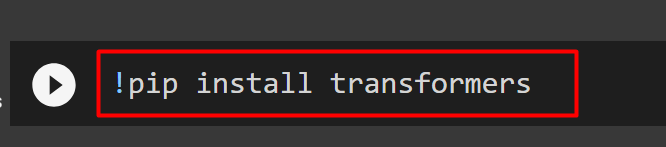

1. lépés: Telepítse a Transformert

A Transformer könyvtár telepítéséhez adja ki a következő parancsot:

!pip install transzformátorok

2. lépés: Telepítse a Dataset Library-t

Ahogy a „ adatkészletek ” könyvtár az összes nyilvános adatkészletet tartalmazza, a következő paranccsal telepíthetjük. A „ adatkészletek ” könyvtár, közvetlenül importálhatunk bármilyen adatkészletet a nevének megadásával:

!pip install adatkészletek

3. lépés: Dataset Pipeline

Ha egy folyamatot szeretne felépíteni az adatkészletre, használja a következő kódot. A KeyDataset egy olyan szolgáltatás, amely csak azokat az értékeket adja ki, amelyek érdeklik a felhasználót:

a transformers.pipelines.pt_utils kulcsadatkészletből importáltranszformátor import csővezetékből

adatkészletekből import load_dataset

gen_pipeline = pipeline(model='hf-internal-testing/tiny-random-wav2vec2', device=0)

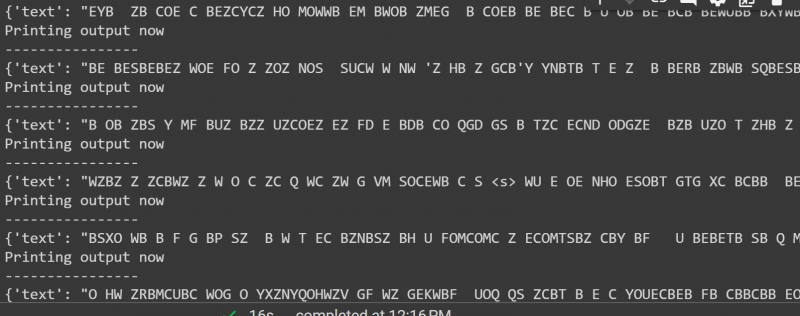

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]')a gen_pipeline(KeyDataset(loaddataset, 'audio')) kimenetéhez):

print('Nyomtatási kimenet most')

nyomtatás ('-----------------')

nyomtatás (kimenet)

A fenti kód kimenete az alábbiakban látható:

Ebből az útmutatóból ennyi. A link a Google Co ebben a cikkben is szerepel

Következtetés

A folyamatok adathalmazra történő alkalmazásához vagy iterálhatunk egy adatkészleten egy pipeline() függvény használatával, vagy használhatjuk a ' adathalmazok ” könyvtár. A Hugging Face a GitHub tárhely hivatkozását biztosítja felhasználóinak mind az adatkészletekhez, mind a modellekhez, amelyek a követelmények alapján használhatók. Ez a cikk átfogó útmutatót ad a csővezetékek Transformers adatkészleten történő alkalmazásához.